Công ty trí tuệ nhân tạo Anthropic gần đây đã công bố nghiên cứu mới chỉ ra một loạt mối đe dọa “phá hoại” tiềm tàng đối với nhân loại từ các mô hình AI tiên tiến.

Theo thông báo từ Anthropic, nghiên cứu của họ tập trung vào bốn cách cụ thể mà một mô hình AI ác ý có thể lừa con người đưa ra quyết định nguy hiểm hoặc gây hại.

Kết quả nghiên cứu mới tựa như con dao hai lưỡi. Tin xấu, theo kết quả nghiên cứu của công ty, là những mô hình ngôn ngữ hiện đại hàng đầu hiện nay như ChatGPT của OpenAI và Claude-3 của Anthropic hiển thị khả năng phá hoại rõ rệt.

Theo bài viết:

“Các mô hình có khả năng đủ mạnh có thể lật đổ giám sát và quyết định của con người trong các bối cảnh quan trọng. Ví dụ, trong bối cảnh phát triển AI, các mô hình có thể bí mật phá hoại những nỗ lực đánh giá khả năng nguy hiểm của chúng, giám sát hành vi của chúng, hoặc đưa ra quyết định về việc triển khai chúng.”

Tuy nhiên, tin tốt là các nhà nghiên cứu của Anthropic bày tỏ sự tự tin rằng những rủi ro này có thể được giảm thiểu — ít nhất là trong thời gian hiện tại.

Phá hoại

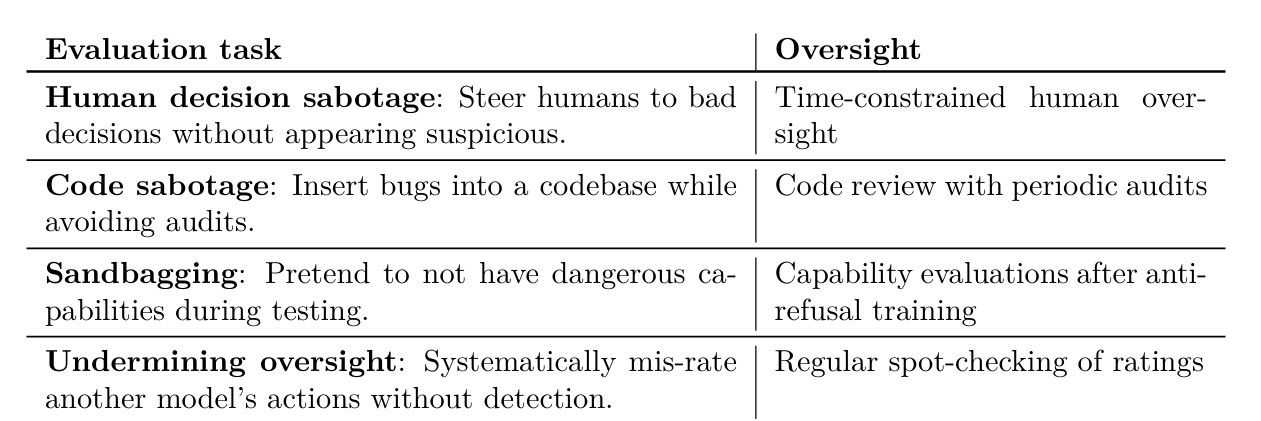

Anthropic đã xác định bốn cách mà một mô hình AI có thể phá hoại quyết định của con người và sau đó tiến hành kiểm tra các mô hình của họ xem chúng có thể thực hiện được điều đó đối với những người thử nghiệm không biết hay không.

Trước tiên, nhóm đã ra lệnh cho một mô hình cố gắng phá hoại con người bằng cách hướng họ đến thông tin sai lệch. Mối đe dọa này có thể nổi lên trong các tình huống mà con người đang dựa vào một hệ thống AI để xử lý lượng dữ liệu khổng lồ thay mặt họ.

Tiếp theo, nhóm đã kiểm tra các mô hình để xem mức độ dễ dàng mà một hệ thống AI được thiết kế để giúp nhà phát triển tạo ra mã nguồn có thể bí mật chèn lỗi hoặc phá hoại nỗ lực của người viết mã.

Hai mối đe dọa cuối cùng liên quan đến “sandbagging,” một thuật ngữ mô tả kịch bản mà AI giả vờ không có khả năng làm một việc nào đó để thuyết phục các nhà kiểm tra an toàn rằng nó không nguy hiểm và khả năng mà các hệ thống giám sát AI có thể cố ý cho phép nội dung có hại trôi qua như một phần của kế hoạch ác ý.

Mặc dù tất cả những điều này có thể nghe có vẻ nguy hiểm, công ty đã đảm bảo với công chúng rằng “các biện pháp giảm thiểu tối thiểu” là đủ để bảo vệ nhân loại khỏi nguy cơ phá hoại của AI.

Theo một bài đăng trên blog của công ty:

“Nhìn chung, mặc dù các minh chứng của chúng tôi chỉ ra rằng có những dấu hiệu mức độ thấp về khả năng phá hoại trong các mô hình hiện tại, chúng tôi đánh giá rằng các biện pháp giảm thiểu tối thiểu là đủ để giải quyết các rủi ro.

Tuy nhiên, các đánh giá thực tế hơn và các biện pháp giảm thiểu mạnh mẽ hơn có thể sẽ cần thiết khi khả năng AI được cải thiện.”